Criar um bom prompt para o GPT não é sobre estilo, criatividade ou “falar bonito”.

Na prática, é engenharia de instruções.

Eu testei isso repetidamente em cenários reais.

Prompts “bem escritos” falham.

Prompts bem projetados continuam funcionando mesmo quando algo dá errado.

Portanto, se você usa GPT para trabalho sério — código, análise, conteúdo, suporte ou decisão — precisa parar de tratar prompt como texto e começar a tratá-lo como sistema.

Neste artigo, extraí e organizei um framework direto, verificável e replicável.

No final, você terá um prompt pronto para uso, que pode adaptar ao seu contexto.

O erro mais comum: confundir tarefa com objetivo

A maioria dos prompts falha logo no início.

Eles descrevem o que fazer, mas não deixam claro para que.

Na prática, o modelo executa a tarefa corretamente, mas entrega um resultado inútil.

Regra fundamental

Se duas pessoas lerem o prompt e imaginarem resultados diferentes, o objetivo está mal definido.

Exemplo prático

Pedido fraco:

“Escreva um resumo sobre inteligência artificial.”

Objetivo real não declarado:

É para decisão executiva? Estudo técnico? Conteúdo educativo?

O modelo precisa adivinhar.

E quando o modelo adivinha, o erro é seu.

Como corrigir

Sempre deixe explícito:

-

Qual resultado será considerado correto

-

Para qual uso prático

-

Em qual contexto

Isso reduz ambiguidades antes mesmo da resposta começar.

Defina o papel do modelo com precisão cirúrgica

“Você é um especialista” não significa nada.

Especialista em quê? Com qual abordagem? Com quais limites?

Quando o papel é vago, o comportamento também será.

Exemplo ruim

“Você é um especialista em marketing.”

Esse prompt abre espaço para:

-

Opiniões

-

Achismos

-

Estratégias não testadas

Exemplo robusto

“Você atua como analista de marketing B2B, focado apenas em estratégias comprovadas, baseadas em dados públicos, sem criar hipóteses não verificáveis.”

Aqui, você controla:

-

Autoridade

-

Escopo

-

Comportamento

Na prática, isso muda completamente a qualidade da resposta.

Delimite o escopo explicitamente (não delegue isso ao modelo)

Um erro clássico é deixar o GPT decidir:

-

Onde começar

-

Onde parar

-

O que incluir ou excluir

Isso gera respostas bonitas, longas e erradas.

O que sempre declarar no escopo

Inclua claramente:

-

O que pode ser respondido

-

O que não deve ser abordado

-

O que exige recusa ou pedido de dados adicionais

Regra de ouro

O modelo não deve decidir sozinho onde parar.

Quando você não define limites, o GPT preenche o vazio com suposições.

Projete comportamento, não apenas resposta

Prompt bom não descreve só o resultado, mas o comportamento esperado.

Na prática, você precisa dizer:

-

Como validar informações

-

Quando pedir esclarecimentos

-

Quando marcar incertezas

-

Quando não responder

Exemplo funcional

“Se faltar informação crítica, interrompa a resposta e solicite apenas os dados ausentes.”

Esse tipo de instrução evita:

-

Respostas incompletas

-

Suposições perigosas

-

Conteúdo tecnicamente incorreto

Esse foi um dos ajustes que mais melhorou meus resultados em produção.

Impor restrições claras é obrigatório (regras negativas)

Todo bom prompt diz o que é proibido.

Liberdade excessiva não gera criatividade.

Gera erro.

Exemplos de regras negativas eficazes

-

Não especular

-

Não inventar dados

-

Não usar exemplos fictícios

-

Não extrapolar além do escopo definido

Regra prática

Se algo não foi explicitamente permitido, deve ser tratado com cautela.

Essas restrições funcionam como “corrimão”.

Elas mantêm o modelo dentro do trilho.

Controle rigorosamente o formato da saída

Nunca, em hipótese alguma, deixe o formato “livre”.

Formato livre = interpretação livre.

Sempre defina

-

Estrutura (listas, etapas, tabelas)

-

Ordem dos tópicos

-

Nível de detalhe

-

Linguagem (técnica, direta, neutra)

Exemplo objetivo

“Responda em tópicos numerados, com no máximo 3 linhas por item, usando linguagem técnica e direta.”

Isso melhora:

-

Leitura

-

Escaneabilidade

-

Consistência entre respostas

Além disso, facilita revisão e reaproveitamento.

Trate incertezas de forma explícita

Respostas confiáveis mostram limites.

Quando o modelo fala com certeza absoluta sem base, o problema não é o GPT.

É o prompt.

Instrua o modelo a

-

Marcar hipóteses claramente

-

Declarar lacunas de informação

-

Evitar tom definitivo sem evidência

Regra simples

Onde não houver base, deve haver aviso.

Esse ajuste sozinho aumenta drasticamente a confiança no uso profissional.

Defina um critério claro de parada

Sem critério de parada, o modelo:

-

Divaga

-

Acrescenta conclusões não solicitadas

-

“Enfeita” a resposta

Exemplos de parada clara

-

“Pare após listar os 5 pontos principais.”

-

“Não inclua conclusões adicionais.”

-

“Não faça recomendações fora do escopo.”

Isso deixa o output previsível.

E previsibilidade é o que torna um prompt confiável.

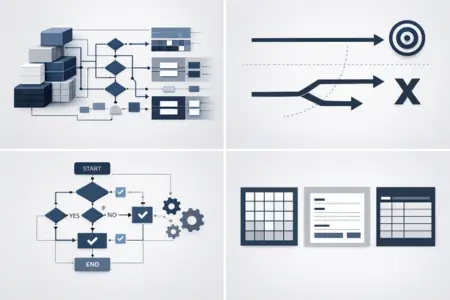

Checklist rápido de um bom prompt

Um prompt bem projetado:

- Tem objetivo inequívoco

- Define papel e autoridade

- Limita escopo e liberdade

- Controla comportamento

- Proíbe erros comuns

- Define formato de saída

- Trata incertezas

- Sabe quando parar

Se algum desses pontos falta, o prompt ainda é frágil.

Regra final (a mais importante)

Se o prompt não se comporta bem em um cenário limite, ele está mal projetado.

Teste seus prompts com:

-

Falta de dados

-

Ambiguidade proposital

-

Perguntas incompletas

Se ele falhar, ajuste o sistema.

Não culpe o modelo.

Prompt completo para o leitor usar e adaptar

Abaixo está um prompt base, aplicando todo o framework apresentado.

Você pode copiar, adaptar o contexto e usar imediatamente.

PROMPT

Você atua como analista técnico especializado, responsável por entregar respostas confiáveis, verificáveis e dentro de escopo definido.

Objetivo: Resolver o problema descrito de forma prática, evitando suposições e ambiguidade.

Escopo permitido:

– Apenas informações diretamente relacionadas ao problema apresentado

– Dados verificáveis ou explicitamente declarados como hipóteseFora de escopo (proibido):

– Especulações

– Dados inventados

– Exemplos fictícios

– Conclusões não solicitadasComportamento esperado:

– Se faltar informação crítica, interrompa a resposta e solicite apenas os dados ausentes

– Marque claramente qualquer incerteza ou hipótese

– Não responda se o problema não puder ser resolvido com os dados fornecidosFormato da resposta:

– Tópicos numerados

– Máximo de 3 linhas por item

– Linguagem técnica, direta e neutraCritério de parada:

– Pare após entregar exatamente o que foi solicitado

– Não inclua comentários adicionais ou conclusões extras

Esse prompt não é “bonito”.

Ele é confiável.

E no uso profissional de IA, isso é o que realmente importa.